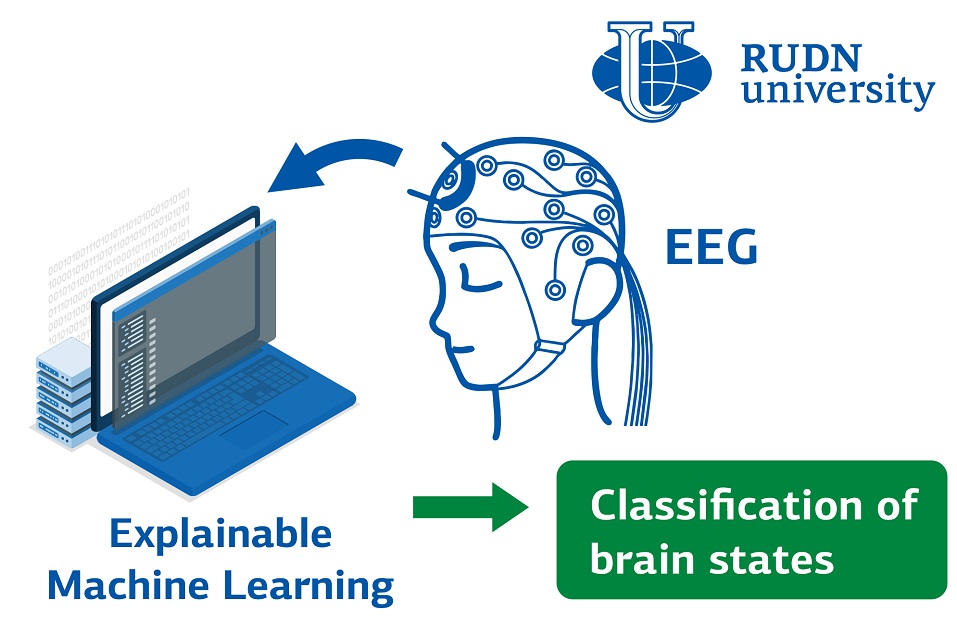

脑部病变诊断的关键阶段之一是成像。这是使用 CT、X 射线、EEG 和其他方法对大脑活动和脑组织进行的可视化。此类分析结果的解释由经过专门培训的专业人员进行。但即使是有经验的眼睛也不能总是得出正确的结论。人工智能可以帮助解释。由于我们谈论的是医生-计算机串联,而不是用人工智能取代人,因此需要这样的模型,不仅可以给出结果,而且可以“解释”为什么会这样。此属性称为可解释性。来自波罗的海联邦大学的一位 RUDN 大学数学家和同事选择了适合此目的的最佳模型。

“人工智能在生物和医学数据分析中是一项重要且积极研究的任务。这也适用于医学图像的分析。这里的中心点之一是可解释性。当医务人员必须理解和解释使用人工智能方法获得的决策时,这对于创建各种辅助决策系统非常重要。因此,开发可解释的不同神经影像学方法具有极大的兴趣。我们的目标是找到一个好的数学模型来对大脑状态进行分类,并强调结果的可解释性,”RUDN 大学交通系首席研究员、物理和数学科学博士 Alexander Khramov。

为了找到最佳模型,研究人员在患者查看不同图像时使用了从患者身上获取的脑电图数据。第一个是蒙娜丽莎的画作,第二个是内克尔立方视错觉,它描绘了一个简单的立方体框架。事实是,该图并没有指出哪些面在前面,哪些面在后面。一个人通常不会注意到矛盾并明确地解释图片,但对于计算机而言,这项任务并不是那么简单。因此,内克尔立方体用于测试人类感知系统的计算机模型。总共有五个人参加了实验。根据脑电图的结果,神经网络必须确定一个人看到的图像的亮度。此外,使用特殊算法,神经网络识别影响模型最终决策的特定参数。

数学家比较了几种人工神经网络模型。具有所谓的自适应梯度Adagrad的模型被证明是最好的。这是一种优化方法,可以根据这个或那个特征出现的频率“调整”神经网络。自适应梯度神经网络达到了 92.9% 的准确率。

“ Adagrad被证明是最好的优化方法。我们的结果将有助于选择合适的机器学习方法来正确训练脑机接口,”RUDN 大学交通系首席研究员、物理和数学科学博士 Alexander Khramov。

视觉感知过程中脑状态分类的可解释机器学习方法

doi : 10.3390/math10152819

科学方向:数学

俄罗斯人民友谊大学(RUDN University )

圣彼得堡科学家谢尔盖·伊万诺夫成为首位获得俄罗斯人民友谊大学国际数学领域科学成就奖(奖金500万卢布)的获奖者。

微藻产品是生物经济领域的前沿发展成果。在金砖国家网络大学国际专题小组“能源” 框架下举行的“绿色可持续能源基础”国际研究研讨会上,讨论了生物资源的潜力。此次活动由俄罗斯人民友谊大学生态研究所组织举办。

从2024年以来,俄罗斯人民友谊大学开始接受新的年度化学领域科学成就奖的申请。该奖项旨在表彰对基础研究和应用研究的贡献以及在实现联合国可持续发展目标方面取得的成就。